时间:2026-01-29 来源:控制科学与工程学院 编辑: 访问次数:13

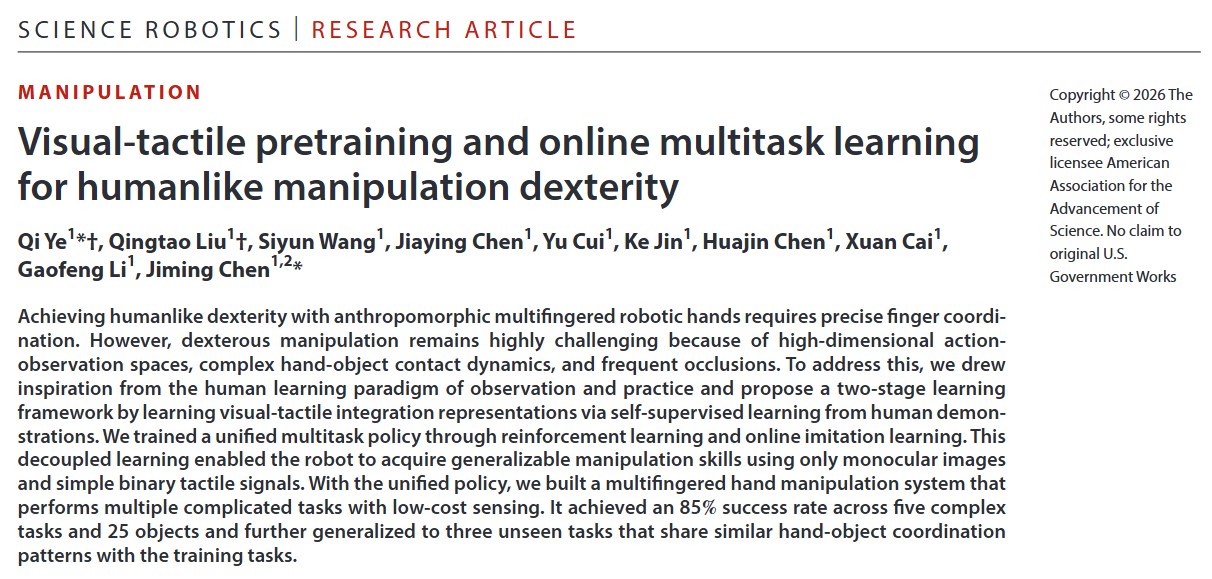

导读:仅凭单目视觉和简单的二值触觉,机器人能否像人类一样玩转复杂的灵巧操作?浙江大学控制科学与工程学院陈积明、叶琦团队与杭州电子科技大学合作者们在国家自然科学基金基础科学中心自主智能无人系统项目支持下,提出了一种受神经科学启发的视触觉预训练与在线多任务学习框架,让灵巧手通过“观察”人类视频学会了多感官融合,仅用极低成本的传感器便实现了高达85%的综合操作成功率,并能泛化到削铅笔、拧螺丝等未见过的任务中。该成果“Visual-Tactile Pretraining and Online Multitask Learning”已于2026年1月28日发表于国际顶级期刊《Science Robotics》。同期的《Science Robotics》发表了针对该成果的前沿聚焦评论文章——“Within arm’s reach: A path forward for robot dexterity”,深度解读该工作并指出该工作提供了一个具有良好可扩展性的算法范式:有效的多模态传感融合、大规模人类数据采集,以及严谨的仿真技术。该成果和专题评论在《Science Robotics》官网首页展示。

首页链接:https://www.science.org/journal/scirobotics

论文链接:https://www.science.org/doi/10.1126/scirobotics.ady2869

聚焦评论:https://www.science.org/doi/10.1126/scirobotics.aee5782

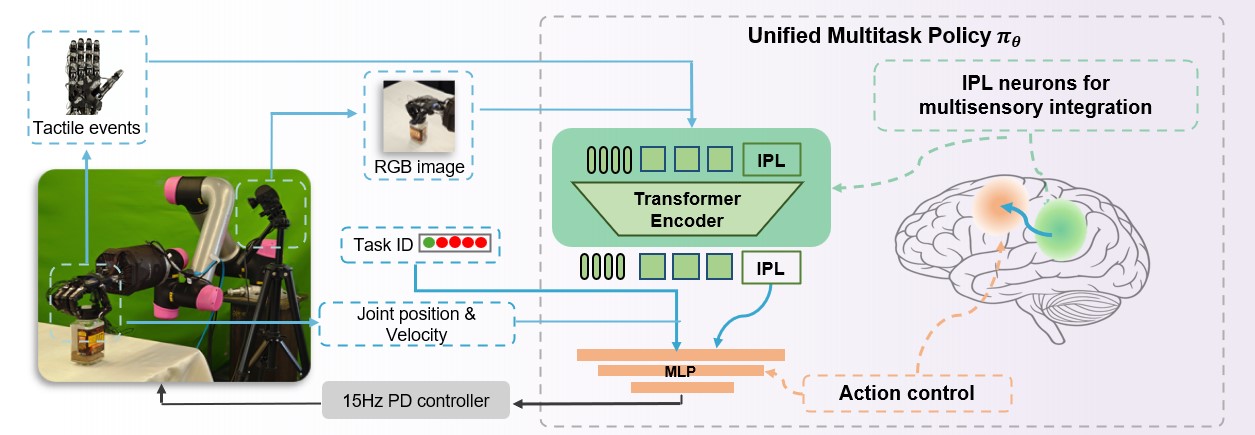

人类的手之所以灵巧,不仅因为有复杂的骨骼肌肉系统,更因为大脑能完美地融合视觉和触觉。神经科学研究表明,人脑顶下小叶(Inferior Parietal Lobule, IPL)中的神经元负责整合这些多模态信息,让我们在行动前就建立了对动作的表达 。受此启发,团队提出了一种全新的学习框架——“Visual-Tactile Pretraining and Online Multitask Learning”。该研究通过模仿人类的学习范式(观察与实践),让机器人仅通过单目RGB相机和低成本的二值触觉传感器,就掌握了包括转瓶盖、拧水龙头、滑动滑块等在内的多种复杂技能,并表现出了惊人的泛化能力和“类人”的操作特性 。

01 挑战:灵巧操作的“维数诅咒”与“感知黑洞”

灵巧手操作一直是机器人领域的“皇冠明珠”,但也是著名的难题。

1.高维动作空间:多指灵巧手拥有20多个自由度,协调它们就像在指挥一支交响乐队。

2.复杂的接触动力学:物体在手中的每一次微小滑动、滚动都涉及复杂的物理接触,极难建模。

3.严重的感知遮挡:灵巧手在操作时,手指不可避免地会挡住相机视线,导致视觉信息缺失。

以往的方法依赖昂贵的高精度传感器(如高分辨率触觉阵列、多视角相机),或者依赖只能在仿真中获取的“上帝视角”状态信息,难以在现实世界的复杂场景中落地 。

02 核心创新:植入机器大脑的顶下小叶“IPL Token”

为了解决上述难题,研究团队提出了一个分阶段的学习框架:

第一阶段:视触觉表征预训练

机器人在这一阶段像婴儿一样,通过“观察”大量人类操作视频来学习。研究者设计了一种基于掩码自编码器的网络,并创新性地引入了一个类似人脑顶下小叶神经元的可学习的视觉和触觉融合的“IPL Token”。

第二阶段:在线多任务模仿学习

有了强大的感知表征后,团队采用了一种在线迭代聚合专家策略的方法。该方法有效地解决了多任务学习中的“观测漂移”问题,让一个统一的神经网络能够同时掌握转瓶盖、滑滑块、重定向物体等多种技能 。

03 硬核实测:从仿真到真机,数据会说话

基于该方法学习的策略,团队搭建了一套低成本感知(普通网络摄像头 + 自制压阻式触觉传感器)的实物灵巧手操作系统 。

一、 一套策略,玩转多变任务

不同于以往“一个任务训练一个模型”的定式,该研究仅训练了一个统一策略,即一个策略完成转瓶盖、拧水龙头、滑滑块、桌面/手内重定向5项任务。

二、 强悍的泛化性:无惧未知物体

对于在训练中未见过的日常物体,包括形状奇特的水果、透明塑料瓶、金属把手等 ,甚至对于训练中从未见过的削铅笔、拧松螺丝和抽薯片内壳套任务,该策略实现了惊人的零样本或少样本泛化。此外,在实验中视觉和触觉融合策略不仅表现为“更能做”,而且“做得更快”。

三、 极致的鲁棒性:黑暗与干扰中依然精准

无惧光照变化:无论是在昏暗的侧光下,还是强光直射的过曝光环境下,凭借触觉信号的补充,机器人依然能精准感知接触状态,完成任务。

传感器普适性:即使更换了不同分辨率、不同原理的触觉传感器(如不同密度的压阻阵列或气压传感器),策略无需重新训练即可适应。

四、视触觉融合填补“虚实鸿沟”

仿真和真实物理视觉上的差异是在仿真训练下操作策略在实物部署面临的重要难题。单模态策略从仿真迁移到真机中,成功率下跌20%以上,而视触觉融合(VT)策略只下降不到5%,证明了多感官融合具有跨越虚实鸿沟的强大潜力。

五、“青出于蓝”:学生策略超越专家

通常的蒸馏学习中,学生网络往往不如专家网络。但本研究发现,基于VT预训练的统一学生策略,其表现竟然超越了专家策略。这说明多任务联合训练让模型学到了相似操作的物理交互规律,实现了“触类旁通”。

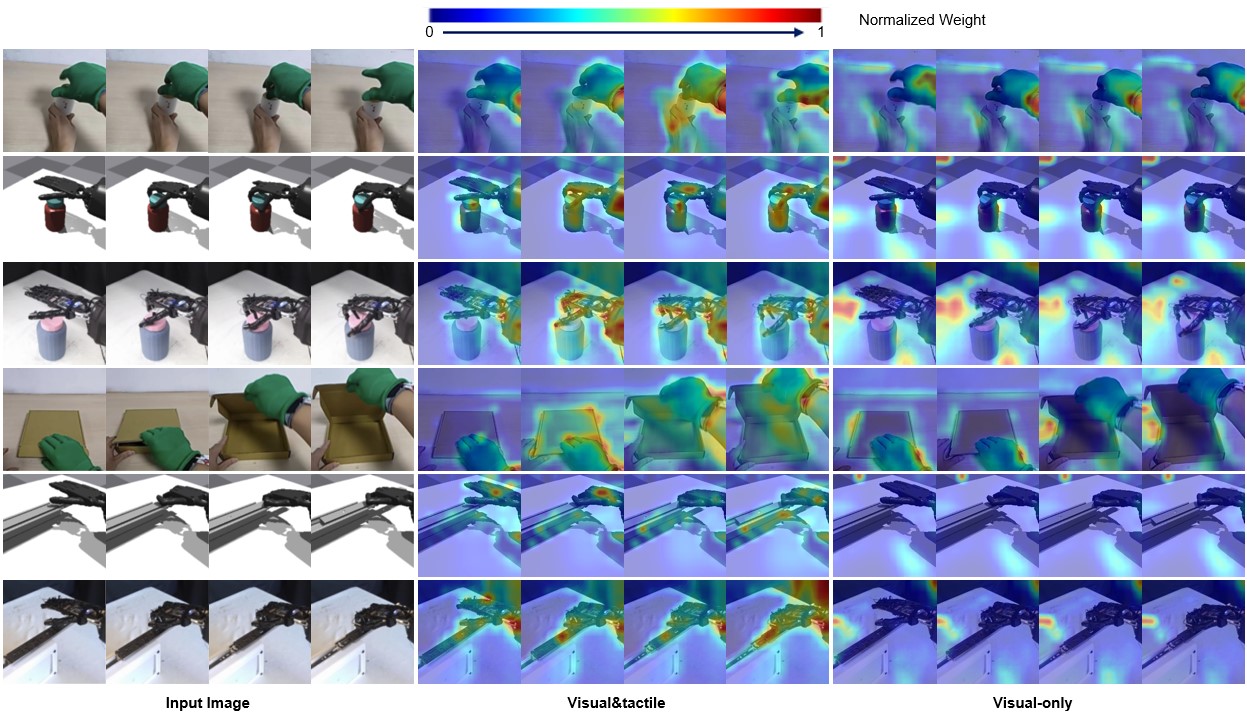

六、像人类一样“注视”关键区域

为什么这套方法这么强?可视化的接触步态和注意力图揭示了答案。

类人行为:统计分析发现,该策略产生的触觉接触模式与人类演示数据高度相似。这说明机器人不仅仅是在机械地执行命令,而是通过预训练,“领悟”了人类操作中细腻的时序与节奏。

意图理解:学习到的“IPL Token”展示出了极强的可解释性。它能够自动忽略背景干扰,将注意力精准地聚焦在手部与物体接触的关键区域。

04 系列工作及未来展望

过去半年,陈积明教授和叶琦研究员团队在机器人领域顶刊TRO, IJRR分别发表百万级灵巧手抓取数据生成和高效灵巧手抓取策略学习成果。在此基础上,团队进一步突破需要手内高度协同的复杂操作任务。这项工作通过引入受脑启发和基于人类视频的预训练,机器人可以在不依赖昂贵硬件的情况下,获得通用的灵巧操作能力。这项技术为未来家用机器人、服务机器人等类人灵巧通用操作提供了一个新的研究思路——也许在不久的将来,你的机器人保姆就能用它灵巧的双手,为你熟练地拧开罐头、整理桌面,甚至削好一只铅笔。

当前位置:

当前位置: